作者:陈剑 来源:X,@jason_chen998

现阶段整个币圈只有三个红利赛道:AI、TG和Meme,而后面两个VC都进不去,再加上上一轮周期币圈太好赚钱了,A16Z、Paradigm、Polychain轻松融了一大堆钱要等着投出去,所以现在都只能疯狂的往AI里挤,所以从融资消化能力看除了大公链外AI则把这些资金都接住了,如之前和大家聊到的Sahara外,Vana也刚官宣拿到了Paradigm、Coinbase、Polychain的投资组合。

把AI+Web3项目分类的话自下到上可以有三层:数据、算力和应用,从产业链的流程来看则是先有数据→再叠加模型→然后用算力训练→最后输送给应用,所以数据作为产业链的最上游,以及其稀缺性来看,也是估值天花板最高的一个板块。

但AI领域的数据问题,以及为什么Web3能解决这问题,我相信大家已经听的耳朵都磨出茧子了,翻来覆去就是什么邪恶无耻的大公司把用户贡献的数据拿去卖钱的车轱辘话,主要是这玩意现在问题就是非常大,但又一直没办法去解决,最典型的案例是Facebook的Meta pixel,全球有30%的网站都安装了这个脚本,会把你使用的数据直接发送给Facebook,以及Reddit和谷歌达成的6000万美金合同,直接把用户的数据给谷歌拿来训练,Youtube、Twiter这些不用说了屁股也一定都不干净,所以如果区块链能把全球最具备红利产业的AI数据平权这么大的问题解决了,那就真从被贴上赌场标签上升到全村的希望了,这是一个光伟正又能融大钱的赛道,所以那些板正的大VC就喜欢投。

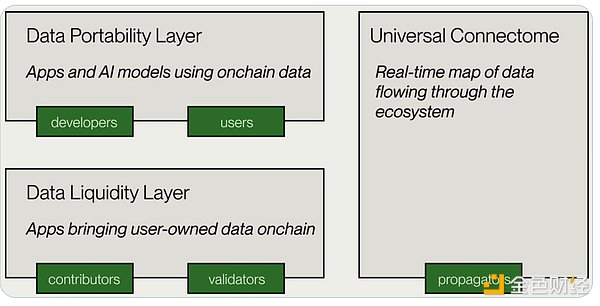

这些年解决数据平权的项目有很多,思路也千奇百怪,但发展的体系化是肉眼可见的在趋于成熟,从一开始只简单将数据上链用于完成确权这个动作,到现在一站式平台化的完善,下图是Vana的架构,其实非常简单只有两层,底层的数据流动性层DLP负责完成收集数据与上链的阶段,上层的数据应用层DPL则给应用提供规整的可使用数据,而整个Vana中最核心的就是DPL,这也是经济模型与空投中最大的一个板块。

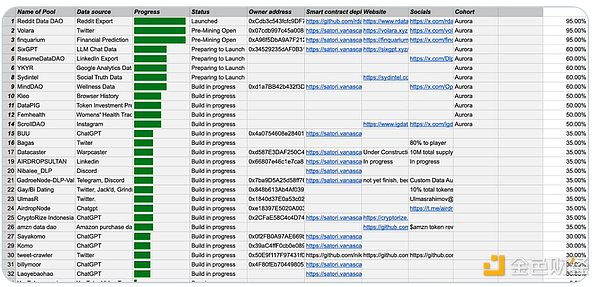

DLP并不只有一个,而是由很多个组成,每个DLP都拥有独立的智能合约、验证方法、节点等体系,值得注意的是尽管申请创建DPL是无门槛的,但在主网上将会只有16个DPL的插槽,而在目前的经济模型中DPL的创建者与参与者将会在两年分到17.5%总量的Token激励,并且排名越高的DPL获得的激励比例也越大,所以这块肉很肥,竞争也很激烈,而DPL的运作机制也是Vana的核心。

DPL就相当于是一个可以由多人贡献的“数据DAO”,它直接对应了特定类型的数据场景,可以由大家一起去给这个DAO贡献数据,比如有TwitterDAO、RedditDAO等,你可以把自己在这些平台的数据通过导出,或者爬虫等各种形式想办法弄出来后,再传上去贡献数据来赚钱,逻辑就是既然这些平台拿着你们的数据去卖,那为什么我不直接做一个公开的数据采买市场,这里面的数据则都由本身的数据拥有者上传,但问题是如何确保这些数据的有效性和全面性,如果只是一个池子大家往里面随意塞数据怎么办?Vana则是通过技术与经济模型治理两个方式来构建DPL体系的。

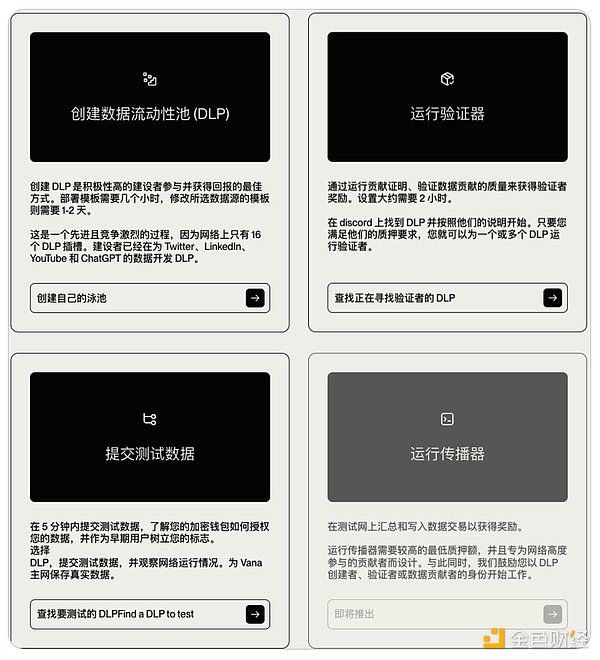

如下图所示在DPL中你可以做四件事情,可以直接创建一个DPL,作为DPL的创建者你是能分到对应40%的Token的,但难度也非常大可不只是简单填个表而已,除了定义你这个DPL的数据来源、类型等基础信息,你还要自己去解决掉智能合约、数据验证方式等一系列问题,因为每一种类型的数据都是不一样的,你又要确保用户传上来的数据是有效的,所以导致不同的DPL验证方式也完全不同,比如你作为TwitterDAO这个DPL的创建者,你得先想办法告诉想贡献数据的用户怎么样才能有效的把自己Twitter数据弄出来,其次更重要的是你还得为此专门开发对应的验证技术,即每当有用户把数据传上来后,需要验证这个数据到底是不是Twitter的、以及数据的格式内容是否有效、是否是机器人造出来的垃圾数据等等一系列问题,所以每个DLP创建者不亚于一家专门解决某个领域数据的专业工作室。

所以直接去创建一个DPL难度对普通人还是非常大的,但如果你本来就是在类似于字节、阿里负责数据分析工作的内部人员,或者是来自哪个专业的大数据公司,那去创建一个DPL则很轻松,一旦被选入主网就是躺赚。

如果没有能力创建DPL就可以做上面的节点,即别人写好验证方式代码后,你作为节点去负责跑代码验证和广播用户提交的数据从而赚钱。

其次作为普通用户,你就可以选择加入一个DPL,按照对应的文档将数据导出后贡献上去,如果你的数据被使用了就可以赚钱。

刚才提到说DPL除了有限的16个外,还会进行排名,排名越高的分到的钱也就越多,这个排名是根据质押Vana币的数量进行的,作为Vana的持有者你可以将币通过质押的方式投票给你认为发展最好的DPL,然后这个DPL的排名也会上升,继而获得更多激励,有钱赚了验证者和贡献者也就越多,形成这样一个正螺旋,作为质押者则可以分到对应DPL激励的20%。

下图为目前测试网阶段的DPL排名,其中有部分已经可以使用了,比如我刚测试了把自己ChatGPT的数据导出后,上传贡献给了其中一个DPL,这些测试网的DPL最终将会有16个胜出进入到主网,所以如果你感兴趣的话可以搞一个DPL上去看能不能抢到位置。

但与此同时的问题是,如何确保DPL的数据不会泄漏,要不然DPL之间互相偷数据,或者第三方不通过平台买直接拿到数据怎么办?首先Vana虽然是一条EVM的Layer1,但这些数据不会全部上链,只将根数据和证明数据上链,其他的数据则通过可信执行环境 (TEE) 通过Intel SGX物理隔离的方式实现数据的不外泄,这一点和我之前给大家介绍过@puffer_finance使用的撕咬保护技术是一致的。

最后虽然也许AI成币圈全村的希望了,但是目前Web3+AI的叙事,也仅仅还停留在叙事而已,真正能否把这一套设计的体系落地还是一个很长期的过程,除去技术外更严重的挑战是商业上是否真的成立,比如作为想采买数据训练模型的谷歌,到底是直接大手一挥花6000万让Reddit把数据库里现成的、规整的数据导出来给他,还是说到某一个平台上去采购由用户自行维护和贡献的数据。在圈内逻辑可以自洽,但是真正到了拼ROI的商战中又能否自洽,还是道阻且长。